Comprendre les LSTM : Long Short-Term Memory

Les Gardiens de la Mémoire

dans le Monde des Réseaux Neuronaux

Boîte à Souvenirs Numérique : Introduction à la Mémoire Artificielle

Imaginez que vous avez une boîte de souvenirs où vous gardez des choses importantes pour vous rappeler des événements passés, comme des photos, des billets de concert, ou même des notes. Dans le monde de l’informatique, les réseaux de neurones sont comme des cerveaux artificiels qui aident les ordinateurs à apprendre et à se souvenir des choses. Mais, comme pour les souvenirs humains, il peut être difficile pour ces cerveaux artificiels de se souvenir de choses qui se sont passées il y a longtemps, surtout lorsque beaucoup de nouvelles informations arrivent constamment.

LSTM : Le Super Cerveau Artificiel : Comment Ça Fonctionne et Ses Avantages

Le réseau LSTM (Long Short-Term Memory, ou mémoire à long terme à court terme en français) est une sorte de cerveau artificiel spécial qui est vraiment bon pour se souvenir des choses sur une longue période. Vous pouvez penser à cela comme à une boîte de souvenirs très avancée dans l’ordinateur qui non seulement garde les souvenirs importants pendant longtemps, mais sait aussi quels souvenirs sont importants et lesquels peuvent être oubliés. Cela permet aux ordinateurs de se rappeler et d’apprendre des motifs ou des tendances dans les données qu’ils voient, comme reconnaître votre écriture ou comprendre ce que vous dites.

Applications dans la Vie Réelle : De la Reconnaissance Vocale aux Soins de Santé

Le problème que résout le LSTM est un peu comme si, dans une conversation, vous oubliez de quoi vous parliez au début de la phrase lorsque vous arrivez à la fin. Les réseaux neuronaux normaux ont du mal avec cela parce qu’ils perdent le « fil » de l’information au fur et à mesure qu’ils apprennent de nouvelles choses, un peu comme si le souvenir s’estompait trop vite. Le LSTM, en revanche, est comme un bon auditeur qui se souvient de tout le contexte de la conversation, même les détails du début, ce qui le rend très utile pour des choses comme comprendre et traduire des langues, reconnaître la parole, et même dans des domaines comme la santé ou les jeux vidéo, où il est important de se souvenir de beaucoup d’informations différentes sur une longue période.

Explication technique

À l’exception du lien vers ‘réseau neuronal récurrent’, veuillez noter que les autres références redirigent vers des contenus en anglais.

Le réseau de mémoire à long terme (LSTM) est un réseau neuronal récurrent (RNN), visant à résoudre le problème du gradient de disparition présent dans les RNN traditionnels. Sa relative insensibilité à la longueur de l’intervalle constitue son avantage par rapport aux autres RNN, aux modèles de Markov cachés et aux autres méthodes d’apprentissage de séquence. Il vise à fournir une mémoire à court terme pour RNN qui peut durer des milliers de pas de temps, donc une « mémoire longue à court terme ». Il s’applique à la classification , au traitement et à la prédiction de données basées sur des séries chronologiques , telles que l’ écriture manuscrite , la reconnaissance vocale , la traduction automatique , la détection de l’activité vocale, contrôle des robots, jeux vidéo, et soins de santé.

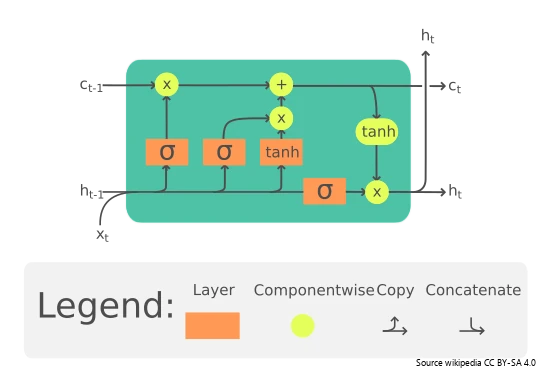

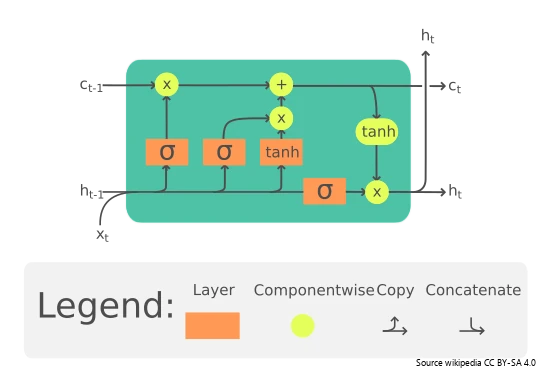

Une unité LSTM commune est composée d’une cellule , d’une porte d’entrée , d’une porte de sortie et d’une porte d’oubli. La cellule mémorise les valeurs sur des intervalles de temps arbitraires et les trois portes régulent le flux d’informations entrant et sortant de la cellule. Les portes Oubliez décident quelles informations ignorer d’un état précédent en attribuant à un état précédent, par rapport à une entrée actuelle, une valeur comprise entre 0 et 1. Une valeur (arrondie) de 1 signifie conserver les informations, et une valeur de 0 signifie Jetez-le. Les portes d’entrée décident quelles nouvelles informations stocker dans l’état actuel, en utilisant le même système que les portes d’oubli. Les portes de sortie contrôlent quelles informations dans l’état actuel doivent être émises en attribuant une valeur de 0 à 1 aux informations, en tenant compte des états précédent et actuel. La sortie sélective d’informations pertinentes à partir de l’état actuel permet au réseau LSTM de maintenir des dépendances utiles à long terme pour faire des prédictions, à la fois dans les pas de temps actuels et futurs.

Motivation

En théorie, les RNN classiques (ou « vanille ») peuvent garder une trace des dépendances arbitraires à long terme dans les séquences d’entrée. Le problème avec les RNN vanille est de nature informatique (ou pratique) : lors de la formation d’un RNN vanille en utilisant la rétro-propagation, les gradients à long terme qui sont rétro-propagés peuvent « disparaître » (c’est-à-dire qu’ils peuvent tendre vers zéro) ou « exploser » (c’est-à-dire qu’ils peuvent tendre vers l’infini), en raison des calculs impliqués dans le processus, qui utilisent des nombres de précision finie. Les RNN utilisant des unités LSTM résolvent partiellement le problème de la disparition du gradient, car les unités LSTM permettent également aux gradients de circuler sans changement . Cependant, les réseaux LSTM peuvent encore souffrir du problème du gradient explosif.

L’intuition derrière l’architecture LSTM est de créer un module supplémentaire dans un réseau neuronal qui apprend quand mémoriser et quand oublier les informations pertinentes. En d’autres termes, le réseau apprend efficacement quelles informations pourraient être nécessaires plus tard dans une séquence et quand ces informations ne sont plus nécessaires. Par exemple, dans le contexte du traitement du langage naturel, le réseau peut apprendre des dépendances grammaticales. Un LSTM pourrait traiter la phrase « Dave, à la suite de ses affirmations controversées, est désormais un paria » en se souvenant du genre grammatical (statistiquement probable) et du numéro du sujet Dave, notez que cette information est pertinente pour le pronom. his et notez que cette information n’est plus importante après le verbe is .

Compréhension du langage naturel.

Retour au glossaire.